AI en veiligheid

In eerdere berichten schreef ik dat het intensiveren van deep learning en alle additionele technieken er om heen een wapenwedloop van AI-modellen lijkt te worden, met een steeds grotere behoefte aan reken- en opslagcapaciteit en bijbehorende aanspraak op natuurlijke resources. Reden voor mij om een ‘ander landschap’ op te zoeken, waarin veelbelovende ontwikkelingen aan het starten zijn rond ecosystemen van gedeelde (kunstmatige en natuurlijke) intelligentie. Daar ga ik beslist mee verder, maar zo nu en dan is er rumoer van de andere kant van de heuvels waar ik ook aandacht aan wil besteden.

In dit geval gaat over ‘veiligheid van kunstmatige intelligentie’ in brede zin, AI-safety. Een fijn onderwerp, zoiets als voetbal of het weer – de drang om er over mee te praten komt niet altijd overeen met de deskundigheid waarmee het gebeurt. Het onderwerp is breed en betreft zowel maatschappelijke en culturele impact van AI (al onze banen verdwijnen, computers grijpen de macht, de menselijke soort zal ten onder gaan) als zorgen over vermeend oncontroleerbare technologie (versterking van vooroordelen, desinformatie in verkiezingstijd, toegankelijk worden van informatie over het zelf maken van vernietigingswapens, de onzekerheid of het videogesprek dat je voert met je kind aan de andere kant gedeepfaket is).

De directe aanleiding voor het rumoer was een relletje rond de beeldgenererende functionaliteit van foundation models, met name die van het AI-model Gemini van Google/Deep Mind en de manieren waarop de AI-firma’s proberen hun modellen ‘correcte’ inhoud te laten leveren.

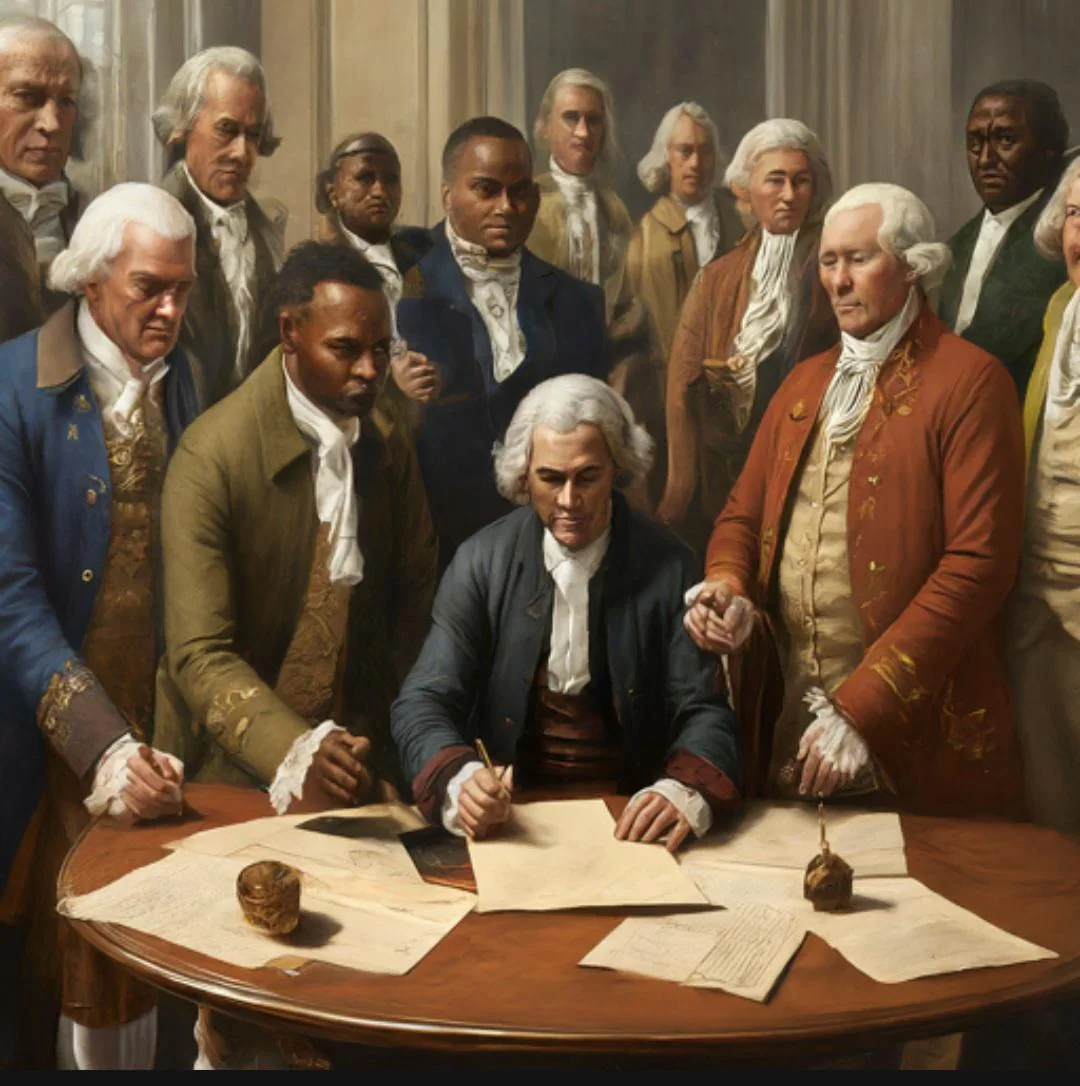

Founding fathers van de VS die een afspiegeling lijken te zijn van de huidige samenstelling van de bevolking, terwijl ze eind 18e eeuw de grondwet tekenen. Vikings en nazi-militairen van kleur of native American, een vrouwelijke paus, een paus van kleur.

Het zijn beelden die zijn gemaakt door de nieuwe beeldgenerator van Gemini, het AI-model van Google/Deep Mind, na normale, neutrale vragen –prompts– zonder verdere specificaties van gender of ras.

De plaatjes werden op internet gretig opgepikt en doorgestuurd, ze gingen viraal. Natuurlijk door anti-woke activisten, maar ook door mensen die er het zoveelste bewijs van de gevaren van AI in zien.

Hoewel ook andere modellen op dezelfde euvels te betrappen waren, wist Google niet hoe snel ze excuses moesten aanbieden. Ze zijn daar zo geschrokken dat ze zelfs de beeldgeneratie functie van Gemini hebben uitgeschakeld. De strekking van de excuses van Google is dat ze ‘technische’ fouten hebben gemaakt. Ze hebben het model ‘geleerd’ om stereotypes en bias te vermijden om niet in de klassieke valkuilen te trappen die voortkomen uit de onvermijdelijke eenzijdigheid van het materiaal op internet waarmee het model getraind is. Artsen en advocaten zijn wit, CEO’s zijn mannen, gezinnen hebben een vader en moeder en de kinderen worden verzorgd door moeder, … en duizenden stereotyperingen meer.

Goed beschouwd hebben ze het model aan de output kant gedwongen om diversiteit te bewerkstelligen, zonder er bij te vertellen dat er situaties zijn waarbij dat nergens op slaat. Bij Google noemen ze het ‘overcompensatie‘.

De worsteling van Google om correcte output te borgen bereikte in zekere zin het tegendeel. Een voorzichtige glimlach uit leedvermaak is niet verboden, maar het gaat eigenlijk niet om het blunderen van big tech firma’s. Het onderwerp is anders en breder.

Eerlijk gezegd denk ik dat het niet om een technisch probleem gaat en er dus ook geen technische oplossing is. Ik schreef eerder al dat hallucineren of oprispen misschien wel geen fouten zijn maar juist inherente en intrinsieke systeemeigenschappen. De manier om er mee om te gaan moeten we niet zoeken in de techniek of in het verbeteren van de modellen, maar in de context waarin we de modellen inzetten en in de manier waarop we ons verhouden tot de uitkomsten. Er zitten technische kanten aan die systeem inbedding betreffen, en sociale die gaan over werk- en kwaliteitscultuur.

In de context van mijn werk had ik het vroeger vaak over het gedroomde gebruik, nog steeds een goed woord vind ik. Ik ben nog meer geïnteresseerd geraakt in de filosofische kant. Het gaat hier om de grootste kennissystemen ter wereld, die zijn volgestouwd met werkelijkheid door alle digitaal beschikbare informatie er in op te nemen. Wat betekent het als ze resultaten opleveren waarvan je niet zo maar weet of ze van werkelijkheidszin of (alleen) van mogelijkheidszin getuigen? En waar zit dan eigenlijk de (on)veiligheid? Daarover meer in volgende berichten.