Kantelpunt: Foundation Models

Een omvangrijk rapport van Stanford University van augustus 2021 introduceert het begrip foundation model. De auteurs zien de opkomst ervan als een ommekeer in AI.

Uit: On the Opportunities and Risks of Foundation Models, Stanford University, 12 juli 2022 (3e versie).

AI is undergoing a paradigm shift with the rise of models (e.g., BERT, DALL-E, GPT-3) trained on broad data (generally using self-supervision at scale) that can be adapted to a wide range of downstream tasks.

We call these models foundation models to underscore their critically central yet incomplete character.

Het rapport is multidisciplinair, met tientallen auteurs onder de vlag van het Center for Research on Foundation Models (CRFM) en het Stanford Institute for Human-Centered Artificial Intelligence (HAI) van Stanford University,

Ik zie het rapport als een van de bepalende, ‘defining‘, documenten op het gebied van AI. In het rapport worden naast de term foundation model een paar andere basisbegrippen gedefinieerd.

De inzet van foundation models heeft in Europa de roep om regulering aangewakkerd, los van de hysterie van het generiek willen beteugelen van Big Tech. Zie ter illustratie twee artikelen in de Volkskrant (van Mark Driessen en Kees Verhoeven op 13 juni 2023 en de reactie van Laura de Vries van 21 juni 2023).

Wat zijn foundation models, en wat maakt ze zo controversieel?

Eerst maar eens de oorspronkelijke definitie (die ook in de synopsis staat):

A foundation model is any model that is trained on broad data (generally using self-supervision at scale) that can be adapted (e.g., fine-tuned) to a wide range of downstream tasks.

Over grote, brede dataverzamelingen hadden we het in vorige berichten, evenals over schaal. Over de training op die verzamelingen (al dan niet onder supervisie) zal het in volgende berichten moeten gaan, hier wil ik de impact van foundation models illustreren aan de hand van twee begrippen die er in het rapport direct mee verbonden worden: ‘emergence‘ en ‘homogenization‘, in beide gevallen toegespitst op de genoemde ‘downstream tasks‘.

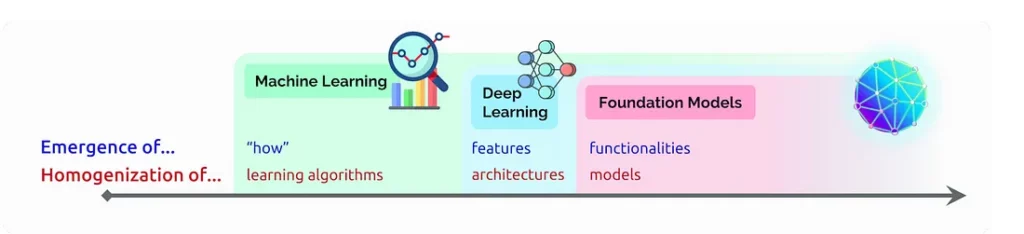

In het rapport staat het volgende plaatje, ter illustratie.

Als ik het goed begrijp zit het zo:

- Het model traint (zichzelf, voor een groot deel) met taken die binnen de dataverzamelingen worden aangeboden en verwerkt. Dit zou je de primaire taken kunnen noemen, hoewel ze in de praktijk vaak schematisch zijn, sjabloonachtig. De vastlegging van het leerresultaat levert die miljarden parameters waarmee de omvang van een model wordt aangeduid.

- Na de training wordt het model losgelaten op ongestructureerde, ongetrainde taken die feitelijk de ‘echte’ opdrachten vormen. Deze afgeleide opdrachten zijn de downstream tasks.

- Nu blijken die grote getrainde modellen, die zogezegd het kantelpunt van omvang en gevarieerdheid voorbij zijn, de afgeleide opdrachten te kunnen uitvoeren zonder dat ze verteld is hoe ze dat moeten doen. Een prompt om ze aan te zetten is genoeg. De oplossingen zijn niet geïnstrueerd, gecodeerd of geprogrammeerd: ze ‘verschijnen’. Dat is het aspect emergence. Dit zou je in bestaand, maar niet zo gangbaar, Nederlands kunnen vertalen als emergentie. Ik voorspel het concept een grote toekomst in de discussies die gevoerd gaan worden.

- Er bij komt dat de downstream tasks alle mogelijke variatie mogen hebben die je maar kunt bedenken. Data in de vorm van tekst, beeld, geluid of wat ook — het maakt niet uit, een foundation model dat multimodaal(*) getraind is pakt ze alle op een vergelijkbare en trainbare manier aan en kan er mee uit de voeten. Dat is het aspect homogenization.

Met name emergence brengt groot enthousiasme, maar tegelijk grote ongerustheid met zich mee. Het is immers impliciet, en daardoor onnavolgbaar, hoe een resultaat tot stand komt. Ook al wil je nog zo graag, je kunt per definitie géén inzicht krijgen hoe een specifiek antwoord is geproduceerd, er valt alleen kennis te nemen van het generieke proces.

Voor toezichthouders en politici is dit een onverdraaglijke gedachte, maar ook wetenschappers en ontwikkelaars zelf vinden het eng.

Zijn we bezig de nieuwe monsters van Frankenstein in elkaar te zetten? Vandaar de roep om regulering, ook bij de sector zelf.

(*) Dall-E, de omgeving die beeld genereert op basis van tekstuele invoer, is een versie van GPT-3 die getraind is op een dataset van ‘tekst-beeld’-paren. Dat heeft 12 miljard parameters opgeleverd die als het ware tekst en pixels uitwisselen. De manier waarop Dall-E resultaten bereikt is volledig vergelijkbaar met de natuurlijke taal-variant van GPT-3. Wel waren er verschillen in de mate van sturing in de training van beide modellen heb ik begrepen.